今日分享来自【KSII TIIS 2021】的论文『DP-LinkNet: A convolutional network for historical document image binarization』。

详情信息如下:

-

作者信息:Wei Xiong, Xiuhong Jia, Dichun Yang, Meihui Ai, Lirong Li, Song Wang

-

单位信息:湖北工业大学电气与电子工程学院;美国南卡罗来纳大学计算机科学与工程系

-

论文链接:http://itiis.org/digital-library/24643

-

项目链接:https://github.com/beargolden/DP-LinkNet

本文简要介绍了作者在ICDAR 2019手机拍照文档图像的时间质量二值化竞赛中的获奖算法[1]。

历史古籍是珍贵的文化遗产,具有重要的科学和文化价值。古籍文档数字化是解决文献保护和文化传承的重要途径。然而,手工处理这些海量文献,不仅费时费力,而且容易出错,因此需要借助计算机对古籍图像进行自动化处理。古籍文档分析与识别(H-DAR)系统应运而生,它主要包括图像预处理、文档图像二值化、版面分析、文本检测与识别等环节。

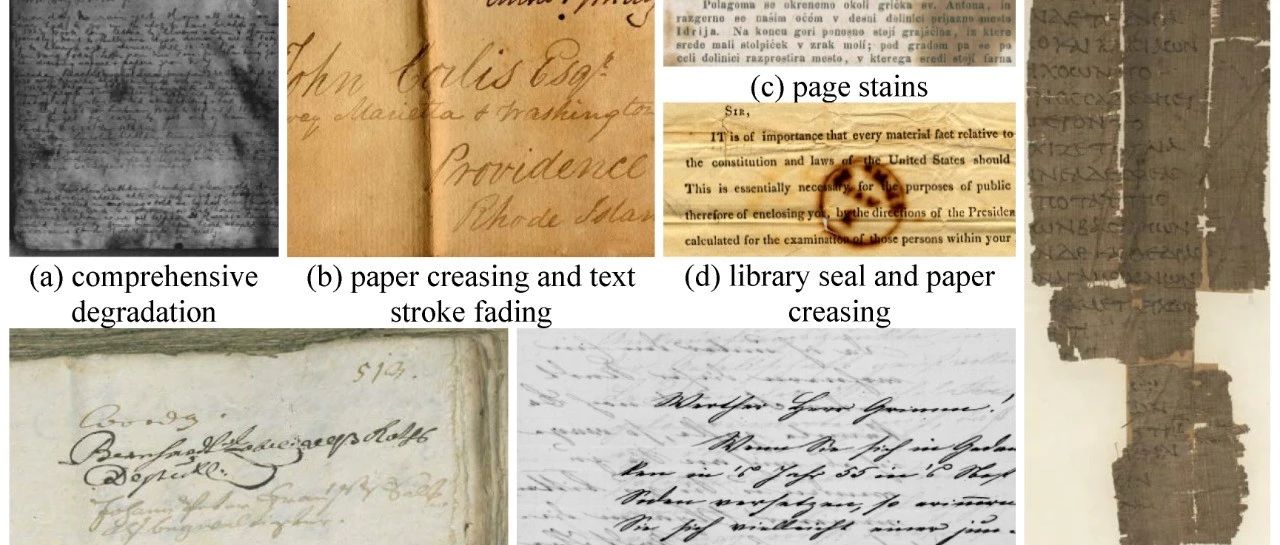

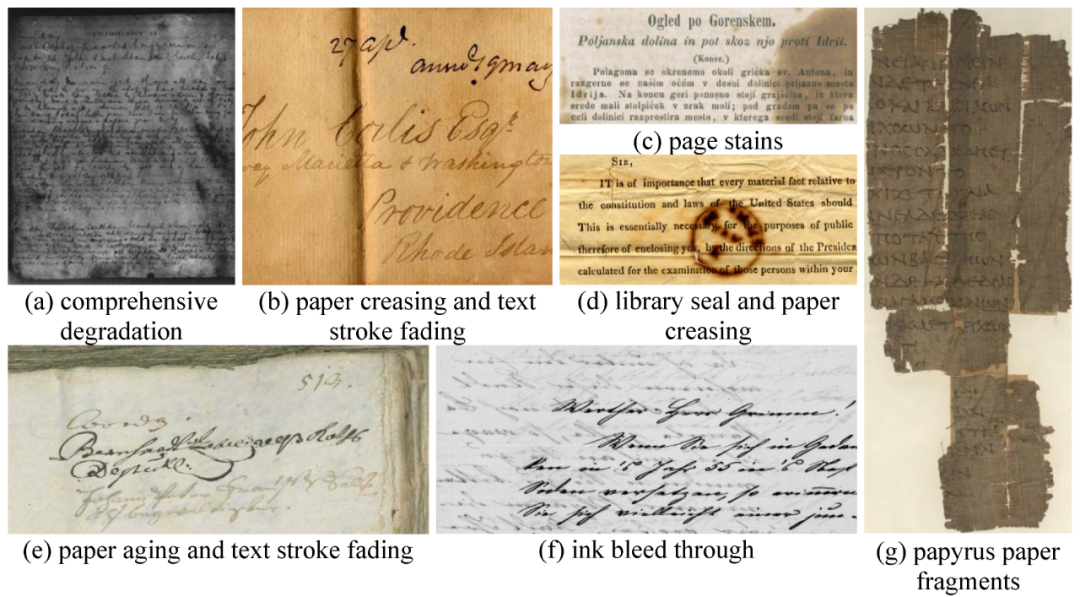

针对现代图书的扫描文档识别技术已经很成熟,但历史古籍的文本识别效果还不理想,而且后者的难度远大于前者,原因在于历史古籍中的文字展现形式极其丰富:(1)允许多语种文本混排,字符具有不同的大小、字体、颜色、亮度、对比度等;(2)文本行可能有横向、竖向、弯曲、旋转、扭曲等样式;(3)图像中的文字区域还可能存在墨迹浸润、印鉴遮蔽、文本残缺或模糊等现象;(4)古籍文档图像的背景变化多样,如纸张老化发黄或页面存在污渍,文字区域附近有复杂的背景纹理或非文字区域有近似文字的纹理等,如图1所示。因此,古籍文档图像分析与识别是一项非常具有挑战性的任务。

图1 古籍文档图像样例,(a)选自Bickley日记数据集,(b)-(g)选自DIBCO竞赛数据集

基于深度学习的图像语义分割模型大多遵循编码器-解码器体系结构,如FCN(全卷积网络)[2]和U-Net[3]。尽管取得了成功,但这类网络模型仍具有三个局限性:(1)连续池化和下采样导致中间层特征图的分辨率下降,(2)文本实例对象的多尺度特性,(3)由于深度卷积神经网络(DCNN)内置的空间不变性,从而降低了空间定位精度。

为了克服第一个问题并有效地生成密集特征图,作者采用了混联空洞卷积(HDC)模块,以使中间特征图更加密集。与使用较大卷积核的标准卷积层相比,空洞卷积层可以在不降低中间特征图空间分辨率的情况下增加感受野的大小。

为了解决第二个问题,可以对图像进行不同比例的裁剪,然后对特征图进行融合。虽然这种方法是有效的,但它引入了太多的计算成本。受空间金字塔池化(SPP)的启发,作者对输入特征图进行不同比例的子采样,以进一步编码全局上下文信息,这样可以在不同尺度上获得目标信息。

DCNN具有空间不变性,即对位置信息不敏感,这对于分类任务来说是可取的,但会阻碍密集型预测任务,如语义分割。因此,解决第三个问题时作者采用的方法是增加跳跃连接来提取不同层次的特征,并在解码器处融合这些特征,以获得分割结果。

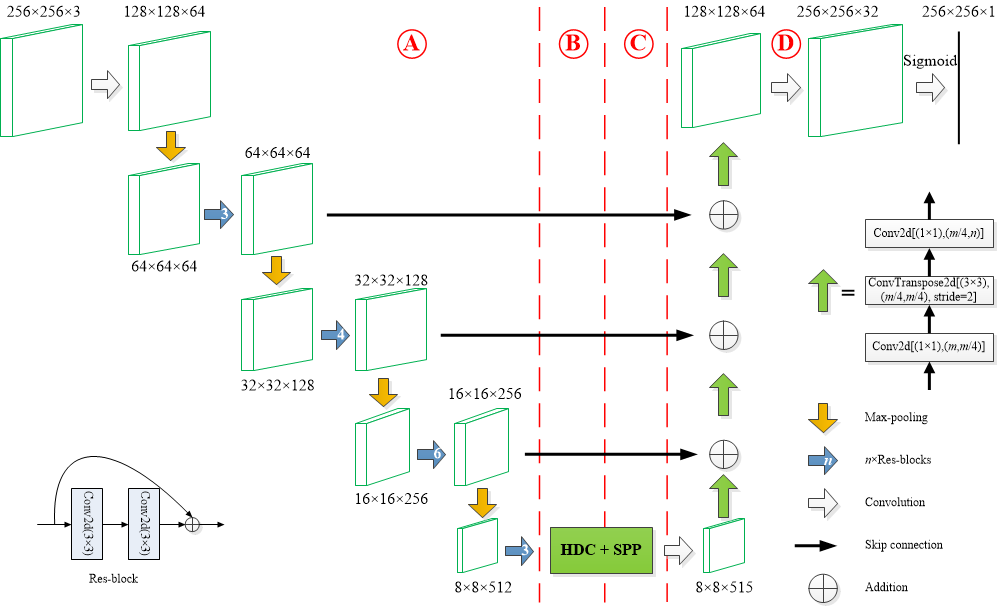

本文提出的DP-LinkNet沿用了LinkNet[4]和D-LinkNet[5]架构,并以预训练好的编码器作为其骨干网络,如图2所示,主要由四个部分组成:编码器(part A)、混联空洞卷积(HDC)模块(part B)、空间金字塔池化(SPP)模块(part C)和解码器(part D)。编码器提取具有深层语义信息的文字笔画特征。

HDC模块扩大了感受野并聚集了多尺度上下文特征,而SPP模块对HDC的输出进行多核池化编码。HDC和SPP模块的组合将产生更为丰富的高层抽象特征图。解码器则将中间部分输出的低分辨率特征图映射回输入图像的大小,并进行逐像素分类。本文提出的DP-LinkNet与前述两个模型的主要区别在于:LinkNet仅包含part A和part D,而D-LinkNet包含part A、part B和part D。

采用在ImageNet[6]数据集上预训练的ResNet-34作为DP-LinkNet的编码器。模型的第一层是一个7×7的卷积层,具有64个输出通道,跨度为2,然后是一个批量归一化(BN)层、一个整流线性单元(ReLU)激活层以及一个跨度为2的3×3最大池化层。编码器的其余部分遵循四个ResNet-34编码器模块,分别由3、4、6、3个剩余块(Res-locks,如图2左下所示)构成。第一个模块中的通道数与该模块的输入通道数相同。由于在每个后续模块的第一个残差块中已经使用了跨度为2的3×3卷积层,因此与前一个模块相比,通道数量增加了一倍,特征图的空间分辨率降低了一半。

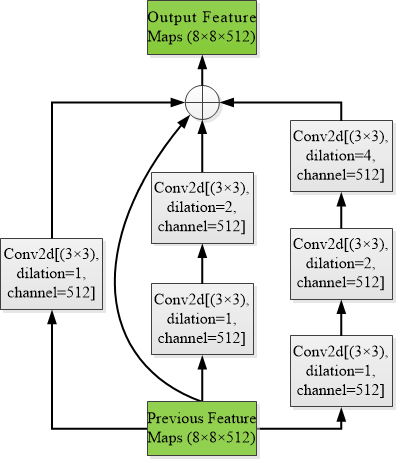

在编码器处要进行一系列的卷积和降采样。这有助于提取高层特征,但降低了特征图的分辨率,并可能导致空间信息的损失。空洞卷积是下采样操作的一种替代方法,已被广泛用于语义或实例分割[7]。它一般有两种模式,即并联模式[8]和级联模式[9],这两种模式都能够显著提高分割精度。受空洞卷积指数级增加感受野大小而不降低中间特征图的空间分辨率这一事实的启发,作者提出了一种混联(即并联+级联)空洞卷积模块,如图3所示。每个分支由1-3个级联空洞卷积组成,卷积核大小为3×3,空洞率分别为1、2、4。因此,每个分支的感受野大小分别为3、7和15。这三个级联的空洞卷积分支与特征图本身相加,然后再送入随后的空间金字塔池化模块。

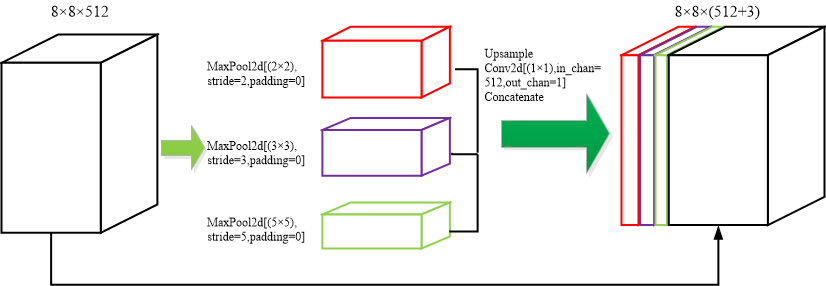

在固定大小的视场下,仍然很难检测或识别不同尺寸的目标对象。因此,受图像分类和目标检测领域SPP-Net[10]的启发,作者采用了空间金字塔池化(SPP)策略来解决上述问题,如图4所示。不同的是,本文提出的SPP模块采用三种不同大小的感受野来编码全局上下文信息,并对HDC输出的特征图进行三次最大池化操作,卷积核大小分别为2×2、3×3和5×5。

在分类应用中,当网络输入为任意大小的图像时,可以进行卷积和池化操作,直到网络即将连接到全连接(FC)层,并通过空间金字塔池化将任意大小的特征图转换成固定大小的特征向量,即利用多尺度特征提取固定大小的特征向量。然而,对于图像分割(可以看作是像素级分类问题),作者将三个低分辨率特征图上采样到与输入特征图相同的空间分辨率大小,最后将输入特征图与这三个经上采样的特征图连接起来。

作者提出的解码器与原始的D-LinkNet一致,而且计算效率更高。它有4个解码器块,每个都包含一个1×1卷积、一个跨度为2的3×3转置卷积以及一个1×1卷积,如图2中的图例所示。与此同时,跳跃连接将来自解码器的粗粒度、深层次的语义特征与来自编码器的细粒度、浅层次的视觉特征融合起来,这可以弥补连续跨度卷积或池化操作造成的空间信息损失。

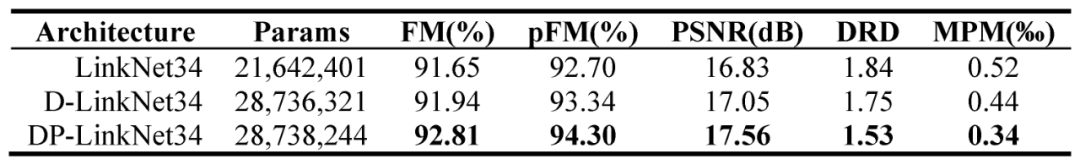

从表1中的数据可以看出,在三个模型的所有评价指标中,仅包含所提架构中A和D部分的LinkNet性能最差。在增加了混联空洞卷积模块后,即包含所提架构中A、B和D部分的D-LinkNet的评价性能要好于LinkNet。本文提出的DP-LinkNet,即在额外的空间金字塔池化模块的帮助下,性能优于其他两个网络模型,而且与D-LinkNet相比,网络参数数量并没有明显增加。实验结果表明,HDC和SPP模块的组合可以有效地进一步提高深度网络的分割性能。

表1 对LinkNet、D-LinkNet和DP-LinkNet的消融研究

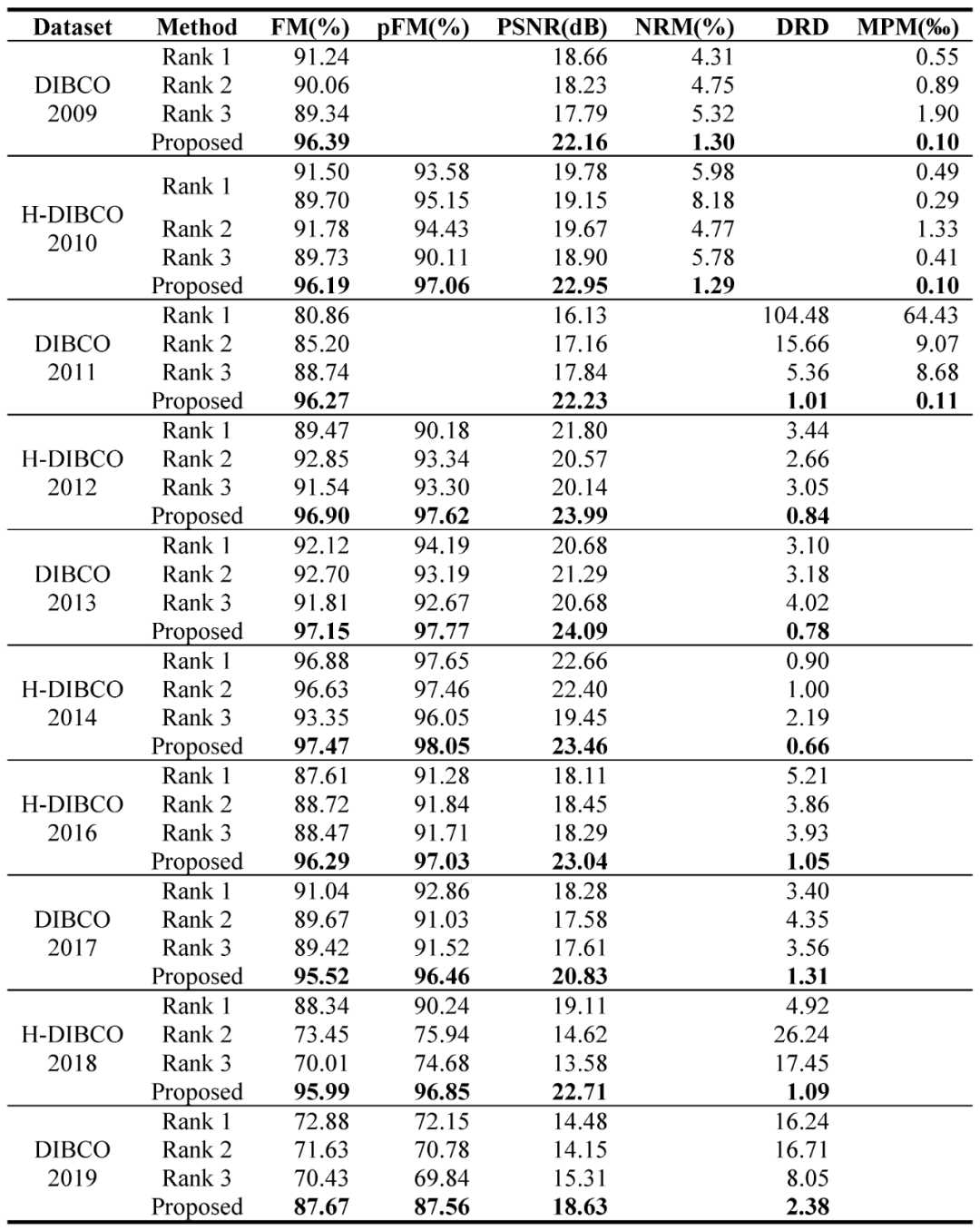

在第一个实验中,作者将本文提出的方法与2009-2019年期间国际文档图像二值化竞赛前三名的方法进行了比较。从表2可以看出,作者提出的方法在所有评价指标中都以较大优势取得了最佳性能。这表明DP-LinkNet可以更好地分割文本像素并保留文本笔画。

表2 与DIBCO/H-DIBCO年度竞赛前三名获奖方法的性能评估结果

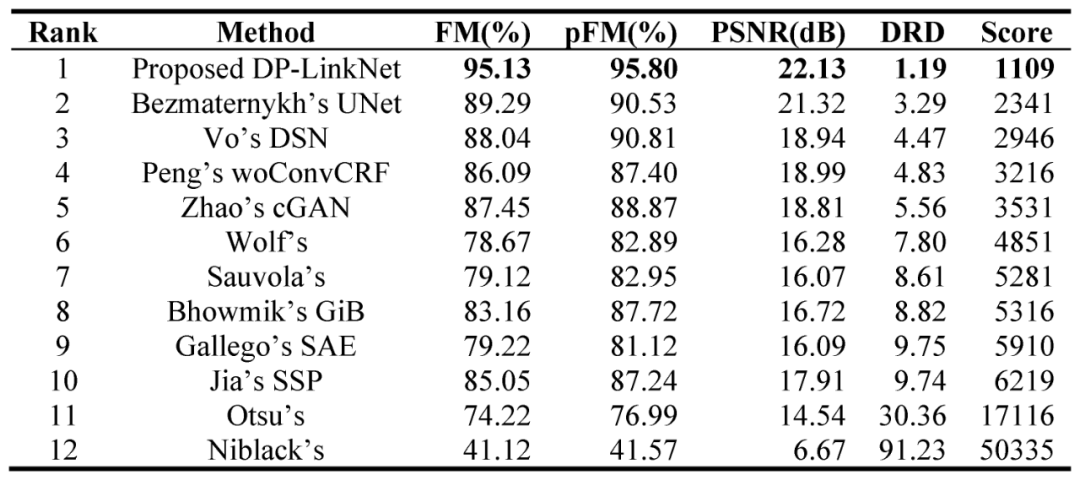

在第二个实验中,作者进一步将本文提出的方法与SOTA方法进行了比较。从表3可以看出,在所有的比较方法中,本文方法的所有评价指标(FM、pFM、PSNR和DRD)都取得了最佳性能,而且根据国际文档图像二值化竞赛中采用的排名得分方案,所提方法的总体性能也是最好的。这意味着DP-LinkNet对各种类型和不同程度的文档退化具有鲁棒性,且能够较好地保留文本笔画。

表3 与SOTA方法在DIBCO/H-DIBCO 10个竞赛数据集上的性能评估结果

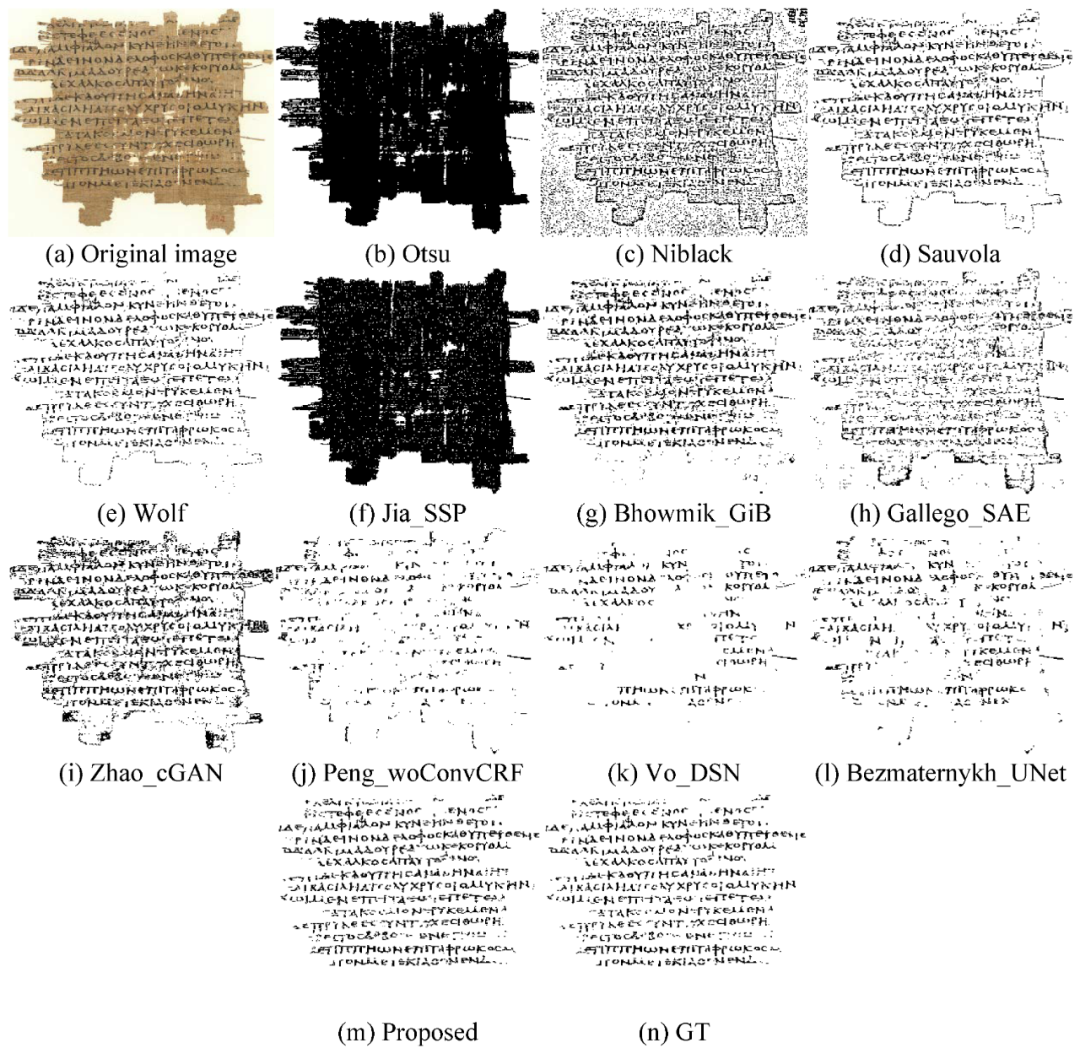

图5定性地展示了本文提出的DP-LinkNet分割方法与SOTA方法对古籍文档图像进行二值化分割的效果对比。实验结果表明,本文方法可以更好地保留文字笔画,并产生更好的视觉质量。

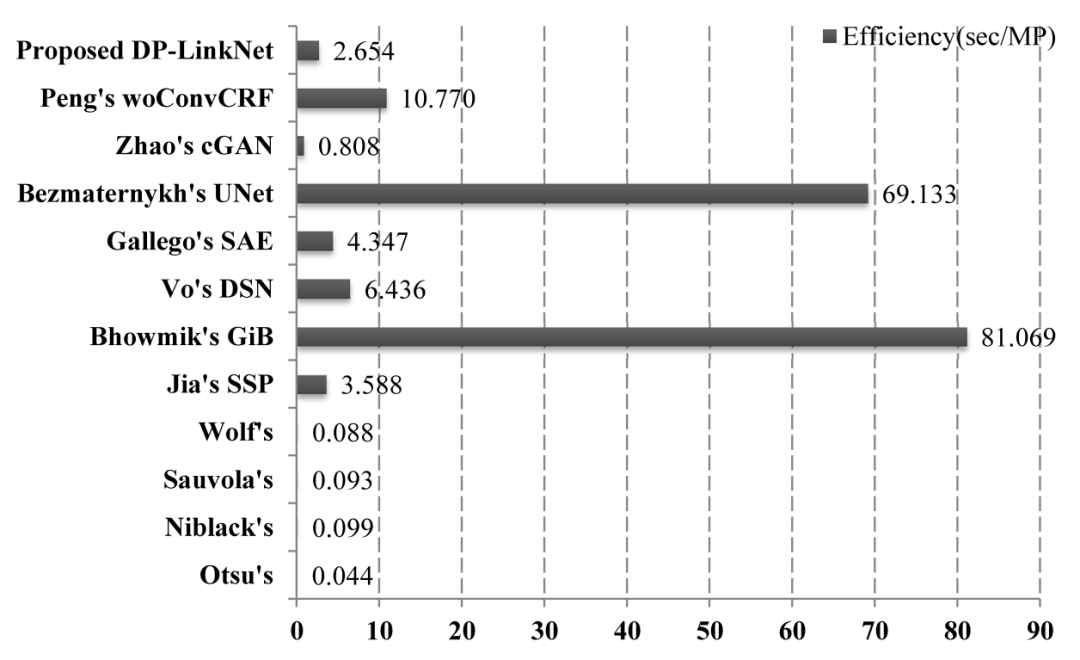

为了让读者更清楚地了解每种方法的执行效率,作者还采用每百万像素的平均运行时间(秒/MP)来评估二值化算法的时间复杂性。实验在以下硬件和软件平台上进行:操作系统为64位Ubuntu 16.04 LTS(Xenial Xerus),CPU为AMD Ryzen5 2600处理器,系统内存为8GB;显卡型号为NVIDIA GeForce GTX 1060(6GB显存),GPU加速库为CUDA 9.0/CUDNN 7.3.1,深度学习框架为PyTorch基础。

从图6可以看出,基于简单统计特征的二值化方法,如Otsu、Niblack、Sauvola和Wolf方法的计算量相对较小,处理速度较快,但二值化性能较差。作者提出的二值化方法,使用TTA(Test Time Augmentation)策略并在测试阶段进行即时数据增强,也比大多数基于CNN或基于复杂文本笔画特征的分割技术快得多。实验结果表明,所提出的DP-LinkNet能够更好地提取文本特征,而且参数更少,不需要加深网络层次。

本文提出了一个名为DP-LinkNet的语义分割网络,用于更准确地对低质量古籍文档图像进行二值化。分割性能的进一步提高主要归功于编码器和解码器之间的混联空洞卷积和空间金字塔池化这两个模块,其中,混联空洞卷积扩大了感受野的大小,而空间金字塔池化则编码了多尺度的聚合特征。

精细的空间信息仍由跳跃连接保持,它将来自解码器的粗粒度、深层次的语义特征与来自编码器的细粒度、浅层次的视觉特征相结合。作者在最近的DIBCO和H-DIBCO基准数据集上进行了广泛实验。结果表明,DP-LinkNet在很大程度上优于其他SOTA方法。

论文地址:http://itiis.org/digital-library/24643

代码地址:https://github.com/beargolden/DP-LinkNet

预训练模型下载地址:[百度网盘] Link: https://pan.baidu.com/s/16bGkVy8su0D-yrazeM_dsA Extraction Code: g12z

[Google Drive] Link: https://drive.google.com/file/d/1A3QeiPwjQM2wUwMwyyWSgT9mzsEx4Q-T/view?usp=sharing

[1] R. Dueire Lins, E. Kavallieratou, E. B. Smith, R. B. Bernardino, D. M. D. Jesus, “ICDAR 2019 time-quality binarization competition,” in Proceedings of the 15th IAPR International Conference on Document Analysis and Recognition (ICDAR 2019), Sydney, NSW, AUSTRALIA, 2019, pp. 1539-1546. doi: 10.1109/icdar.2019.00248

[2] E. Shelhamer, J. Long, T. Darrell, “Fully convolutional networks for semantic segmentation,” IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 39, no. 4, pp. 640-651, 2017. doi: 10.1109/tpami.2016.2572683

[3] O. Ronneberger, P. Fischer, T. Brox, “U-Net: Convolutional networks for biomedical image segmentation,” in Proceedings of the 18th International Conference on Medical Image Computing and Computer-Assisted Intervention (MICCAI 2015), Munich, GERMANY, 2015, pp. 234-241. doi: 10.1007/978-3-319-24574-4_28

[4] A. Chaurasia, E. Culurciello, “LinkNet: Exploiting encoder representations for efficient semantic segmentation,” in Proceedings of the 2017 IEEE Visual Communications and Image Processing (VCIP 2017), St. Petersburg, FL, USA, 2017, pp. 1-4. doi: 10.1109/vcip.2017.8305148

[5] L. Zhou, C. Zhang, M. Wu, “D-LinkNet: Linknet with pretrained encoder and dilated convolution for high resolution satellite imagery road extraction,” in Proceedings of the 31st Meeting of the IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops (CVPR 2018), Salt Lake City, UT, USA, 2018, pp. 192-196. doi: 10.1109/cvprw.2018.00034

[6] J. Deng, W. Dong, R. Socher, L.-J. Li, K. Li, F.-F. Li, “ImageNet: A large-scale hierarchical image database,” in Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR 2009), Miami Beach, FL, USA, 2009, pp. 248-255. doi: 10.1109/cvpr.2009.5206848

[7] L.-C. Chen, G. Papandreou, I. Kokkinos, K. Murphy, A. L. Yuille, “DeepLab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs,” IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 40, no. 4, pp. 834-848, 2018. doi: 10.1109/tpami.2017.2699184

[8] L.-C. Chen, Y. Zhu, G. Papandreou, F. Schroff, H. Adam, “Encoder-decoder with atrous separable convolution for semantic image segmentation,” in Proceedings of the 15th European Conference on Computer Vision (ECCV 2018), Munich, GERMANY, 2018, pp. 833-851. doi: 10.1007/978-3-030-01234-2_49

[9] F. Yu, V. Koltun, “Multi-scale context aggregation by dilated convolutions,” in Proceedings of the 4th International Conference on Learning Representations (ICLR 2016), San Juan, Puerto Rico, 2016

[10] K. He, X. Zhang, S. Ren, J. Sun, “Spatial pyramid pooling in deep convolutional networks for visual recognition,” IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 37, no. 9, pp. 1904-1916, 2015. doi: 10.1109/tpami.2015.2389824

文本检测、识别、编辑等更多最新技术,若已为CV君其他账号好友请直接私信。

在看,让更多人看到

原文始发于微信公众号(我爱计算机视觉):论文推荐|【KSII TIIS 2021】DP-LinkNet:一种用于古籍文档图像二值化的卷积网络(有源码)