数据科学和数字艺术史

作者介绍

作者:列夫•马诺维奇(Lev Manovich),美国纽约城市大学研究生中心的计算机科学教授,数字人文研究领域的重要学者,成果丰硕。著有《新媒体语言》(The Language of New Media, The MIT Press, 2001)、《软电影:数据库导航》(Soft Cinema: Navigating the Database, The MIT Press, 2005)等著作。

译者:刘探宙,南京大学商学院硕士研究生。

本文译自《数字艺术史国际期刊》(Lev Manovich, “Data Science and Digital Art History,” International Journal for Digital Art History, June 2015, issue 1, p. 12–35)。

内容摘要

本文介绍了若干数据科学中与数字艺术史、运用定量方法来研究任何文化产品或一般流程相关的概念。这些概念有对象、特征、数据、特征空间和降维。这些概念同时支持对大量视觉文化数据进行的计算勘探。我们可以分析单个艺术家作品、多个艺术家、某段历史期间所有数字化作品、博物馆馆藏、收藏或有关艺术的著作之间的关系。同样的概念也允许我们用大量的社会媒体内容来研究当代方言视觉媒体(在我们的实验室中,我们分析了梵高、蒙迪里安和罗斯科的作品,6000幅法国印象派油画,20000张现代艺术博物馆(MoMA)摄影收藏的照片,100万张从漫画书中挑选的漫画页面,100万件当代非专业艺术家的艺术作品,和来自全球16个城市的1300多万幅Instagram图片)。虽然数据科学不能够替代其他艺术史方法,但它们让我们从新的视角重看了熟悉的艺术史料,并研究当代数字视觉文化。

除了与艺术史和数字人文学科的相关性外,这些概念本身也很重要。任何想要了解我们的社会如何“用数据思考”的人都需要理解这些概念。在过去几年中,计算机科学家对社交媒体中的文化模式进行了数以万计的定量研究。更一般地,这些概念隐藏在数据挖掘、预测分析和机器学习及其众多行业应用的背后。事实上,它们和我们用来代表和推理世界和彼此的其他古老文化技术一样,是我们“大数据社会”的核心——自然语言、保存和访问信息的材料技术(纸张、印刷、数字媒体等)、计数、微积分,或基于镜头的照片和视频成像。简而言之,这些概念构成了数据社会的“头脑”——接触、理解和作用于我们时代特定世界和人类的特殊方式。

关键词:数据科学;数据挖掘;可视化;数据分析;特征;元数据;社会媒体;算法;数据集

引言

艺术史是否会完全适应定量和计算技术作为其方法的一部分?虽然在2000-2015这十五年中计算分析在文学研究和历史中的使用一直在缓慢但有系统地增长,但在涉及视觉(艺术史、视觉文化、电影和媒体研究)的领域尚未出现这种情况。

然而,学术界采用定量方法的历史表明,这些领域迟早也会经历自己的“定量转变”。阿德里安·拉夫特里(Adrian Raftery)在2001年撰文指出,心理学在20世纪20至30年代率先采用定量统计方法,随后在20世纪30至40年代经济学开始采用,社会学始于1960年代,政治学则在上世纪90年代开始采用计量统计方法[2]。现在,在2015年,我们也知道,涉及文本和空间信息的人文领域(即已提及的文学研究和历史)自2000到2010年也正在经历这一过程。因此,我期待“人文视觉”数字化也即将到来。

[1] 致谢:本文借鉴了2007年至2015年间软件研究计划(Software Studies Initiative)的研究。我要感谢所有参与我们项目的研究生和本科生,以及我们的外部合作者。我们的工作得到了安德鲁·梅隆基金会(Andrew Mellon Foundation)、国家人文基金会、国家科学基金会、国家能源研究科学计算中心(NERSC)、研究生中心、纽约城市大学(CUNY)、加州电信和信息技术研究所(Calit2)、加州大学人文研究所、新加坡教育部、现代艺术博物馆(MoMA,NYC)和纽约公共图书馆的支持。

[2] Andrian Raftery, “Statistics in Sociology, 1950-2000: A Selective Review”, Sociological Methodology, Vol. 31, 2001, pp. 1-45, https://www.stat.washington.edu/raftery/Research/PDF/socmeth2001.pdf (accessed April 24, 2015).

然而,这种适应不会仅仅意味着找出什么是计数,然后使用经典的统计方法(在20世纪30年代发展起来,直至今日几乎仍以同样的方式教给无数的本科生和研究生)来分析这些数字。相反,它将发生在21世纪初的基础社会和文化发展内容中——在“大数据”以及一套被称为“数据科学”的新方法、惯例和技能的兴起过程中。数据科学包括19世纪和20世纪早期的经典统计技术,20世纪60年代开始在计算机的帮助下发展起来的数据分析的附加技术和概念,同时大量领域衍生出的概念也围绕着计算机在20世纪下半叶得到发展:模式识别、信息检索、人工智能、计算机科学、机器学习、信息可视化、数据挖掘等。尽管“数据科学”这一术语是最近才使用的,但它非常有用,因为它充当着当前最常用的计算数据分析方法的保护伞。(或者,我可以选择机器学习或数据挖掘作为本文的关键术语,但由于数据科学包括它们的方法,我认定如果我必须要使用单个术语来代指计算数据分析整体,“数据科学”无疑是最好的。)

数据科学包括很多已经发展了几十年的观点和数以百计的算法。这听上去很多,也确实如此。这远比能在一两节研究生方法课、在一篇文章中能总结的内容,或在一本教科书中提出的知识要多。但是,更有必要的是理解整个领域最基本的假设,而不是简单地从大量的数据科学中挑选特定的算法和技术,或者借用任何最新换言之目前最流行的技术(例如“主题建模”或“深度学习”),就直接试图将它们运用到艺术史中。也就是说,我们在艺术史(或任何其他人文领域)需要学习在当代社会使用数据科学的核心概念。这些概念不需要公式来解释,它们可以在一篇文章中介绍,这就是我在这篇文章中尝试的。(一旦我们定义了这些核心概念,当今数据科学中使用的各种术语也会减少入门者的困惑。)

令人惊讶的是,在过去八年中,我阅读了数千篇文章和各种教科书后, 没有发现任何一篇文章中将这些核心概念放在一起介绍。当然,虽然许多数据科学教科书确实在讨论它们,但它们的介绍往往侧重于数学上复杂的技术或特定的应用的背景下,这会使人们难以理解这些想法的一般性[3]。如果没有计算机科学背景,这些教科书阅读起来也会充满挑战性。

[3] For example, David Hand, Heikki Mannila, and Padhraic Smyth, Principles of Data Mining, Cambridge, Mass.: The MIT Press, 2001; Jure Leskovec, Anand Rajaraman, and Jeff Ullman, Mining of Massive Datasets. 2n ed., Cambridge: Cambridge University Press, 2014; Nina Zumel and John Mount, Practical Data Science with R, Shelter Island: Manning Publications, 2014.

由于我的文章是为人文学科的读者撰写的,它的目的便具有偏向性——应用数据科学核心概念的例子来自人文学科,而不是经济学或社会学。每当我有一个论述,便会提出一个论点。因数据科学的某些部分比其它部分更与人文研究相关,我建议初学的“定量人文学者”应该首先注重学习和练习这些技术。

一、从世界到数据

如果我们想要使用数据科学来“理解”某些现象(即计算机之外的某些现象),我们如何开始?与处理数据(如经典统计和数据可视化)的其他方法一样,数据科学从以特定的方式表示某些现象或过程开始。此表示形式可能包括数字、类别、 数字化文本、图像、音频、空间位置或元素之间的连接(即网络关系)。只有在构造了这样的表示形式之后,我们才能使用计算机处理它。

一般来说,创建这样的表示形式需要做出三个关键决策:

第一,这种现象的界限是什么。例如,如果我们有兴趣研究“当代社会”,我们怎样才能做到这一点,或者如果我们想要研究“现代艺术”,我们将如何选择时间段、国家、艺术家、艺术品,或其他需包含的信息呢?在另一个例子中,让我们假设我们对当代的“业余摄影”感兴趣。我们应专注于研究 Flickr 上的特定群体,这些团体包含自称为业余或半专业摄影师的人的贡献,还是该从 Flickr、Instagram或其他媒体共享服务中广泛采样——毕竟今天每个拥有自带内置摄像头手机的人,都能自动成为摄影师。

第二,我们将表示的对象是什么。例如,在现代艺术示例中,我们可以包括以下“对象”(在数据科学中,它们也可以称为数据点、记录、样本、测量等),个人艺术家、个人艺术品、艺术家间的通信、艺术期刊的评论、艺术书籍中的一段文章、拍卖价格等,都可以是表示的对象,但不限于此(例如,2012年在纽约现代艺术博物馆[MoMA]举办的发明抽象展览,展示了一个基于艺术家间信件交换数量,体现的是艺术家之间联系的网络可视化[4]。在这个表现中,现代主义抽象艺术是由艺术家之间的一组连接来表现的,而不是我上面列出的任何其他对象)。例如,在“社会”示例中,我们可以随机选择大量的人,并研究他们共享的社交媒体、他们的人口和经济特征、他们彼此之间的联系,以及他们所佩戴传感器记录的生物模式。如果我们想要了解一家医院的工作模式,我们可以将人(医生、护士、患者和其他人员)作为元素,也可以将医疗程序、医疗测试、有关医疗生成的书面文档和医疗图像等作为元素。

[4] MoMA (Museum of Modern Art), Network diagram of the artists in Inventing Abstraction, 1910-1925 exhibition, 2012, http://www.moma.org/interactives/exhibitions/2012/inventingabstraction/?page=connections (accessed April 24, 2015).

第三,我们将研究的每个对象的特征有哪些(这些也称为元数据、特征、属性或特征)。在人文学科中,我们通常将已作为数据的一部分提供的特征(因为有人已经记录过)和我们添加的特征(例如通过标记)作为元数据。在社会科学中,手动添加数据描述的过程称为编码。在数据科学中,人们通常使用算法自动从对象中提取其他特性(characteristic),它们被称为特征(feature)(此过程称为“特征提取”)。例如,艺术家的名字是元数据的示例;他们绘画的平均亮度和饱和度,或他们作品所有标题中使用的单词长度,都是计算机可以提取的特征示例。通常要素是数值描述(整数或小数),但它们也可以采用其他形式。例如,计算机可以分析图像并生成几个描述图像内容的单词。通常,元数据和要素都可以使用各种数据类型:数字、类别、自由文本、网络关系、空间坐标、日期、时间等。

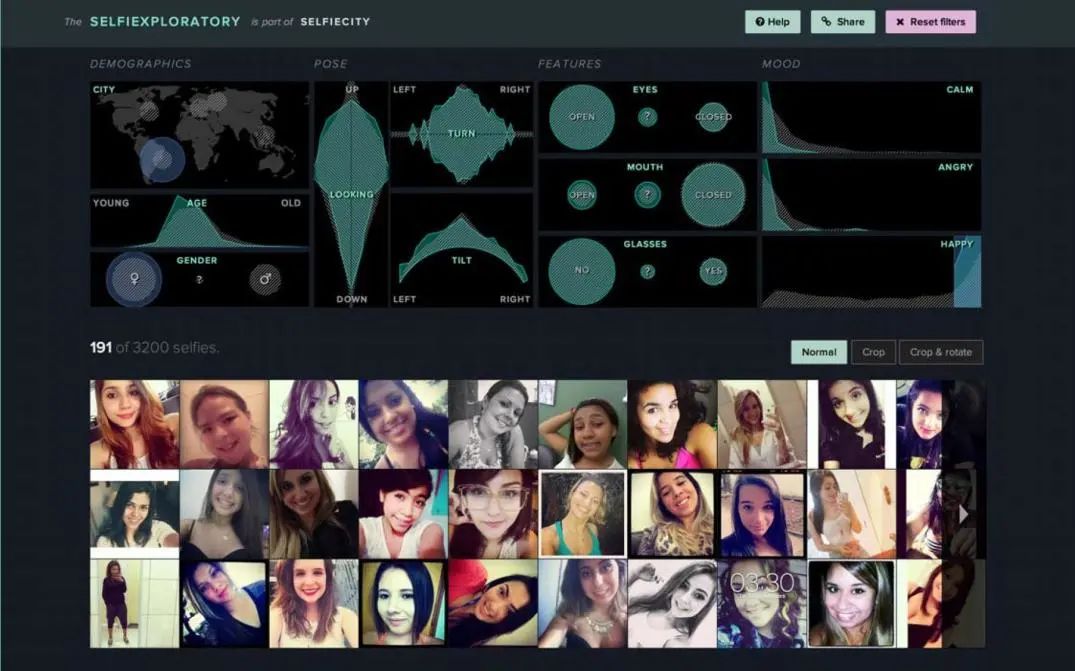

图1 展现我实验室一个项目中使用的元数据和特征的示例。我们收集了 3200 个 Instagram 上的自拍(self-potrait),并创建了一个交互式网络(Web)界面来探索此集合。元数据的示例与共享 Instagram 图像的城市相同。这些特征包括估计人的年龄和性别,以及计算机分析的结果(情绪、面部位置和方向、是否微笑以及微笑的次数等)。

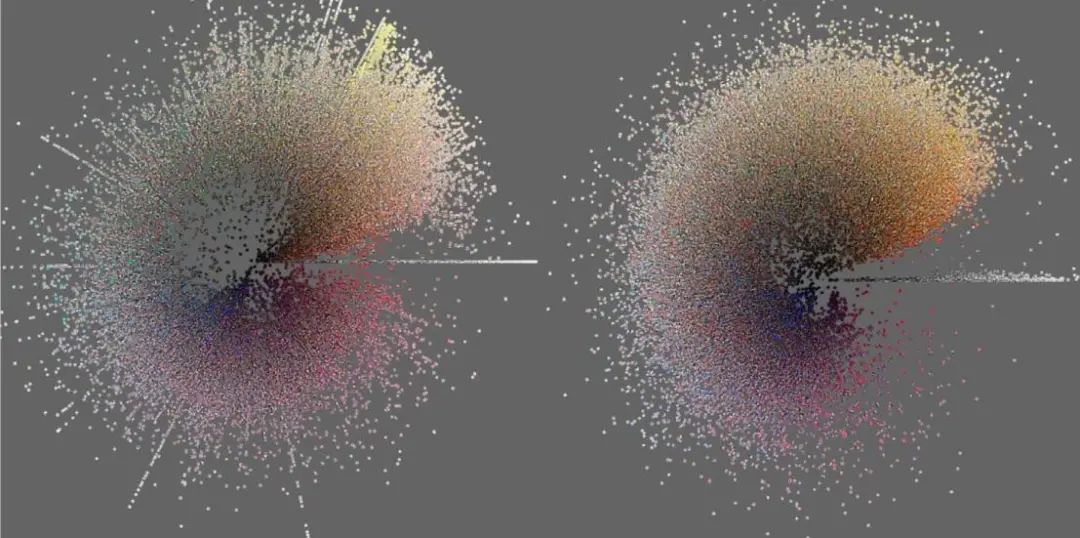

图2 展现使用特征显示大量图像集合的可视化示例。将在曼谷共享的50,000张Instagram图像与在东京共享的50,000张Instagram图像进行比较,这些图像是使用计算机分析提取的两个特征——平均色彩饱和度和平均色调。

我建议在数字艺术史上,我们将术语“特征”适应以代指通过计算机分析和现有的元数据可以从对象中提取的信息。在自然科学和社会科学中,最常见的术语是“变量”,它用于实验的语境中。但是由于在人文学科中,我们不像科学那样做系统实验,因此对我们来说,“特征”一词更好。它只意味着我们根据对象的各种特征来表示对象,但这并不意味着任何特定的分析方法。(但是,在下面的“经典统计和统计图表”一节中,我将使用“变量”,因为这是本节所述期间使用的术语。)

尽管将上述三个问题视为创建数据表示(限制范围、选择对象和选择其特征)过程中的三个阶段是合乎逻辑的,但不必按这种线性顺序进行。在此研究的任何时候,我们都可以添加新对象、新对象类型和新特性。或者,我们可以发现,我们想要使用的特征并不实用,因此我们必须放弃我们的计划,并尝试研究其他特征。简而言之,生成表示形式并使用计算机技术处理它的过程可以并行进行,并相互驱动。

根据我们的观点,我们可以假设一种现象(例如“当代社会”)不管我们如何研究它,它都是客观存在的(即我们使用什么作为对象及其属性)。或者,我们也可以假设一个现象等于一组对象及其属性,用于不同的定性和定量研究、出版物和关于它的传播(书籍、文章、大众媒体、学术论文等)。也就是说,一种现象是由它的表现和关于它的对话构成的。我把对上述三个问题的描述放到了第一个位置,这样做主要是为了方便解释“从世界到数据”的步骤。

二、对象+特征=数据

一组对象及其特征共同构成“数据”(或“数据集”)。

数字人文学科的学者总是喜欢提醒我们,数据是“构造的”——它并不仅仅存在在那里。但这到底是什么意思呢?任何数据项目、出版物或数据可视化都包括现象的某些方面,不包括全部方面,因此它总是“有偏的”。但是在大多数情况下,这都是可以纠正的。例如,在社交媒体使用情况调查中,若只对美国人进行抽样调查,并询问他们有关社交媒体使用的具体问题(如受欢迎的Pew互联网调查),我们可以添加来自不同国家的人,也可以询问他们其他问题。但是,“数据”的概念也包含着无法改变的更基础和根本的假设,这同样重要。在我们使用计算机分析现象或活动之前,必须将其表示为一组有限的单个对象及其特征的有限集。以音乐为例,音乐的计算分析通常将音轨划分为非常小的间隔,例如 100 毫秒,并测量每个样本的某些属性。这样,模拟介质就变成了离散数据。

当今某些现象的“数据表示”与人类迄今为止使用的其他文化表现形式有什么不同,它们是具象绘画、文学叙事、历史记述或手绘地图?首先,数据表示形式是模块化的,即它由单独的元素组成:对象及其特征。其次,这些特征以我们计算的方式进行编码。这意味着这些特征可以采用多种形式——整数、浮点数、表示为整数或文本标签的分类等等,但不只是任何形式。而且每个特征只能使用一种格式。

但在我看来,最关键和最有趣的区别是,数据表示形式有两种明确分离的“事物”:对象及其特征。选择哪些作为对象、选择哪些特征,以及这些特征如何进行编码,这三个决策对于将现象表示为数据同样重要,因此,要通过数据科学技术,使它们可计算、可管理和可知。

实际上,对象和特征可以通过多种方式整理,但最常见的一个是熟悉的表。如果我们用一些字符(如制表符或逗号)分隔单元格(这些字符分别存储为.txt 或.csv 文件),则表也可以存储为标准文本文件。关系数据库是许多通过共享元素连接在一起的表。

表具有行和列。最常见的情况是,每一行被保留以表示一个对象;列用于表示对象的特征。这是当今最常见的数据表示方式,被用于每个专业领域,所有自然和社会科学以及政府服务。这是数据社会理解现象和个人的方式,并针对它们采取行动。

三、经典统计学与现代数据科学:

从一个变量到许多变量

(一)经典统计和统计图:处理一个或两个变量

统计来源于“国家”一词,它在18和19世纪的兴起与现代官僚主义的形成密不可分,“全景监狱”社会(“panopticon” societies)关注计算、认识和控制它的人类主体及其经济资源。直到19世纪中叶,“统计”的含义才发生变化——它成为一个独立学科的名称,涉及对任何数字集合进行汇总和推理,而不是只对国家和行业。

为了我们的目的——理解当代数据科学的核心原则,以及它们与经典统计学的差别——我们可以分三个阶段划分统计学的历史。第一阶段包括18世纪和19世纪前半叶。在这一阶段,统计意味着收集和对各种社会和经济数据进行表列。在此阶段,威廉·普力菲尔(William Playfair)和其他人开发了多种绘图技术,以直观地表示此类收藏。普力菲尔因引入四种基本技术而备受赞誉:条形图和折线图 (1786年),以及饼图和扇形图(1801年)。普力菲尔首次收集了使用这些技术的书籍的标题,集合了推动发明这些技术的数字收集类型:《商业和政治地图集:以染色铜板图方式呈现18世纪英国的商业、收入、支出和债务》(1786年);《统计摘要:基于一个全新原则对欧洲各国资源的展示》(1801年)。

尽管后期还发明了其他数据可视化技术,普力菲尔发明的这些图形技术在今天仍然最为流行。注意到它们都只重视可视化所研究对象的单个特征。它们内置于所有统计和图形软件和Web服务中,它继续塑造当今人们使用和思考数据的方式——即使计算机可以执行更多操作!(备注:在Excel等程序中创建图表时,通常还会选择额外的一列包含标签。因此,即使这些技术只显示单个特征中的模式,即存储在单个列中的一些数字,以便包括行的标签,也使用第二列,但它不计为数据变量。)

在19世纪,专题性的地图(topical map)也变得流行起来。例如,国家地图中每个部分的亮度表示一些统计数据,如识字率、犯罪率等[5]。尽管此类地图也是用二维图形表示,但它们仍然仅使用单个变量(即使用数量来阻止——挖掘地图上显示的每个区域的亮度或图形样式)。

[5] For historical examples, see Michael Friendly and Daniel Denis, “Milestones in the History of Thematic Cartography, Statistical Graphics, and Data Visualization” (n.d.), http://datavis.ca/milestones (accessed April 24, 2015).

在统计史的第二阶段(1830-1890年代),分析和图形技术被开发出来以研究对象两个特征(即两个变量)之间的关系。在1880年代,弗朗西斯·高尔顿(Francis Galton)引入了相关性和回归的概念。高尔顿可能也是第一个使用我们现在所知的散点图的技术的人。如今,散点图仍然是将两个变量绘制在一起的最流行的技术[6]。

[6] Michael Friendly and Daniel Denis, “The Early Origins and Development of the Scatterplot,” Journal of the History of the Behavioral Sciences, Vol. 41, No. 2, 2005, pp.103-130, http://www.datavis.ca/papers/friendly-scat.pdf (accessed April 24, 2015).

19世纪最著名的统计用途之一就是那个时期的“数据想象”。19世纪30年代,比利时人阿道夫·奎特莱(Adolphe Quetelet)测量了许多不同年龄的儿童和成人的身高和体重,并在《关于人及其才能发展的论文》(1835年)这部名著中发表了他的结果。奎特莱的结论是,这些特征测量在大量的人遵循钟状曲线(称为现在高斯或正态分布)。除了将身高和体重作为单一变量进行分析外,奎特莱还分析了许多人之间的关系,在 1832 年创建了现代“身体质量指数”。他发现,平均而言,“体重随着身高的平方而增加”[7]。

[7] Quoted in Garabed Eknoyan, “Adolphe Quetelet (1796–1874)—the average man and indices of obesity,” Nephrology Dialysis Transplantation, Vol. 23, No. 1, 2008, pp. 47-51, http://ndt.oxfordjournals.org/content/23/1/47.full (accessed April 24, 2015).

更多规范的例子可以在被认为是社会学的创始文本——埃米尔·杜尔凯姆(Émile Durkheim)的《自杀》(1897年)一书中找到[8]。这本书有几十个数据表。杜克海姆使用此类汇总统计数据比较不同人群的自杀率(抗议者与天主教徒、单身与已婚、士兵与平民等)。然后,他提出了这些差异的理论解释(请注意,本书没有单独的统计图表,也没有对任何统计检验的意义进行区别)。

[8] Émile Durkheim, Le Suicide. Étude de Sociologie, Paris, 1897.

在第三阶段(1900-1930年),对一个或两个变量的分析的统计概念和方法得到了进一步的改进、扩展、系统化,并给出了严格的数学基础。其中包括汇总数字集合中心趋势的度量值(如平均值和中位数)和集中趋势测量(如方差和标准差),分析两个变量(相关性和回归)之间的关系,进行统计测试,并设计用于收集数据的实验以便用统计进行分析。这一时期的关键工作是由卡尔·皮尔逊(Karl Pearson)、查尔斯·斯皮尔曼(Charles Spearman)、在英国工作的罗纳德·费舍尔(Ronald Fisher)和美国的查尔斯·皮尔斯(Charles Pierce)完成的[9]。

[9] For a highly influential presentation of statistics in this period, see Ronald A. Fisher, Statistical Methods for Research Workers, Edinburgh: Oliver and Boyd, 1925, http://psychclassics.yorku.ca/Fisher/Methods/index.htm (accessed April 24, 2015).

当代大学生统计入门教科书的内容与费舍尔1925年出版的《研究工作者的统计方法》一书的内容非常相似,我们可能想知道在“大数据”的今天,为什么还在继续使用计算机时代以前提出的概念和工具。手工计算的实用性是20世纪初统计整理人员的重要考虑因素。这种考虑在形成学科方面起到了关键作用,因此仍然构成我们对数据社会的“想象”。

(二)现代数据科学:共同分析许多特征

在20世纪,统计逐渐发展出分析多变量的方法(即“多变量分析”)。二战后使用数字计算机进行数据分析促进了这一发展。随着计算机的计算速度越来越快,分析越来越多的特征变得更为现实。到21世纪初,现象的表现形式具有成百上千个特征已经司空见惯。使用大量功能描述对象的假设是数据科学的标准,这是它与经典早期统计的区别之一。

虽然目前基本统计类仍然侧重于分析一个或两个变量的技术,但数据科学总是处理许多特征。这是为什么呢?在社会科学中,目标是解释,其理想的方法是系统性实验。实验的目的是研究某些条件如何影响现象或活动的某些特征。例如,一个人的背景(出生地、族裔、教育程度等)如何影响她目前的职位和薪水,运动员的准备和饮食如何影响她在多项体育比赛中的表现,如果有很多因素和影响,就很难理解具体是什么和在影响什么。因此,在一个理想的20世纪实验中,研究者只想测量一个条件和一个效应。在一个实验中,一个条件(称为自变量)是系统性变化的,并记录受此条件影响的单个特征的值(称为因变量)。实验后,使用统计技术(绘图、相关性、回归等)来研究两个变量之间的可能关系。

在现代数据科学中,关键目标是自动化。数据科学(如人工智能领域)旨在自动化知识的决策、预测和生产。如,根据有关客户的可用信息,银行应向该客户提供贷款吗,照片是否包含人脸,此人脸与数据库中的现有面孔匹配吗,根据搜索引擎用户键入的短语,哪些网页与该短语最相关。原则上,如果一个人或一个团队花费足够的时间研究所有相关信息并给出答案,那么这些问题中的每一个都会得到很好地解答。但是,这需要很多时间才能得到一个答案。鉴于在许多情况下(例如,Web包含大约 140-150 亿个网页)中可用的信息规模,时间将接近无穷大。此外,数据可能包含多少不同的条件(变量),即使是无限的时间也不会帮助人类完全理解它们的效应。

因此,信用排名系统、人脸识别系统、搜索引擎和我们社会中无数其他技术系统,使用数据科学算法和技术,来自动执行此类任务。总之,数据科学的目标是人类认知功能的自动化——试图让计算机完成人类的认知任务,而且速度要快得多。

实现这一目标并不容易,因为计算机科学与人类语言存在“语义差距”。这是人类可以从某些数据中提取出的知识与计算机分析相同数据之间的差距。例如,查看一个人的照片,我们可以立即检测出照片显示的是人形,将人物与背景分开,了解一个人的衣着、面部表情等等。但对于计算机来说,照片只是颜色像素的矩阵,每个像素由三个数字定义(红色、绿色和蓝色的不同比例组成不同颜色),计算机必须使用此“低级”信息来尝试猜测图像表示的内容及其表示方式。理解文本的含义是语义差距的另一个示例,人类读者了解文本的内容,但计算机只能“看到”一组用空格分隔的字母。

试图“缩小语义差距”(这是计算机科学出版物中的标准用语)是使用多种特征的动机之一。例如,在图像分析的情况下,除了各行RGB值的像素,计算机算法还可以提取图像的各种特征。计算机可以识别具有相似颜色值的区域,并测量图像许多部分的线条方向和纹理属性,希望达到的是所有这些特征加在一起能够包含足够的信息,以便算法识别图像表示的内容。

总之,20世纪统计分析和当代数据科学使用变量的方式正好相反。统计和定量社会科学想要分离自变量和因变量,因为其目标是了解现象。数据科学则倾向于使用许多特征,寄希望于它们一起可以包含用于自动化识别、分类或其他认知任务的正确信息。

四、特征空间

在继续之前,我们快速总结一下到目前为止我们学到的关于将现象表示为数据的内容。我们将现象表示为具有特征(也称为属性、特征、变量或元数据)的一组对象(也称为数据点、度量、样本或记录)。总之,对象及其特征是指“数据”(或”数据集”)。特征可以通过多种方式表示:整数和小数、类别、空间坐标、形状和轨迹、日期、时间等。

这些是现代数据分析和数据可视化的基本要求或约定。现在,让我们开始下一“课”。对于上述概念——对象和特征,我们将添加第三个核心概念——特征空间。

我们假设我们的数据存储在一个表格中。但现在,我们将数据表概念化为一个具有许多维度的几何空间。每个特征都将成为其中一个维度。每个对象都成为此空间中的点。这就是一个“特征空间”,在我看来,它是当代数据科学中对人文科学最重要、也是最相关的一个概念。

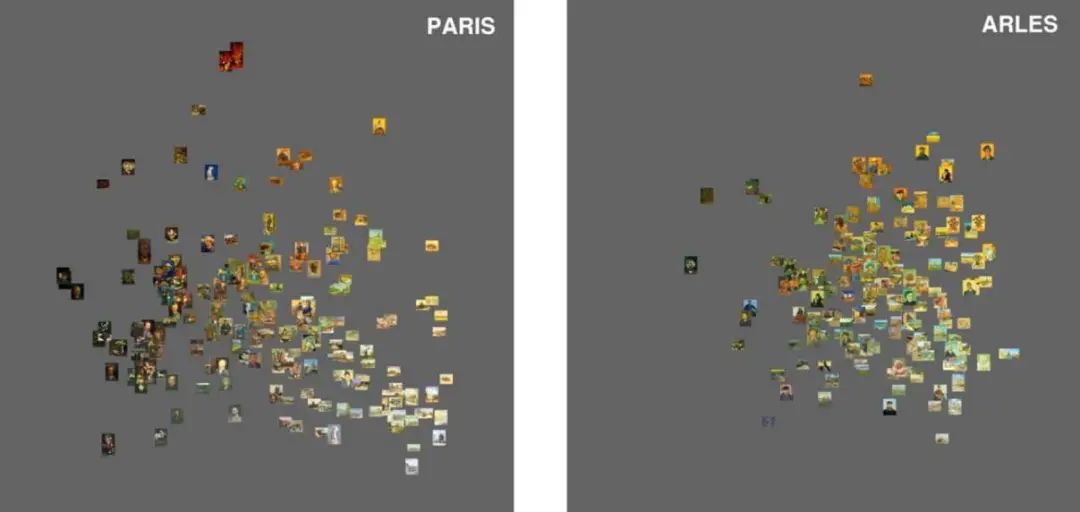

理解这一点的最简单方法是考虑熟悉的二维散点图。此类图表示两个维度中的数据。一个维度 (X)对应于一个特征(即数据表中的一列);第二个维度 (Y) 对应于第二个特征(表中的另一列)。(图3使用有两个特征的空间来比较文森特·梵高在巴黎和阿尔勒创作的绘画)。

图3 比较梵高(van Gogh)在巴黎(左)和阿尔勒(右)创作的绘画亮度和饱和度。X 轴 = 平均亮度;y 轴 = 平均饱和度。可视化显示,在这些维度上,梵高的巴黎画作比他的阿尔勒画作更具可变性。我们还可以看到,在阿尔勒创作的大多数绘画与巴黎绘画占据的亮度/饱和空间相同;只有一小部分阿尔勒的画探索这个空间的新部分(右上角)(列夫·马诺维奇的可视化作品/软件研究计划)。

如果我们想要添加第三个特征,在软件允许的情况下,我们可以制作一个三维散点图。如果我们有十个特征,我们的绘图现在理论上将存在于一个十维的空间中,以此类推。然而,即使数学和计算机科学可能处理任意维度数的空间,我们人类无法直接看到或绘制它们,因为我们存在的物理空间只能让我们看到三个维度。但是我们仍然可以使用计算技术来思考多维空间中的对象,并研究它们之间的关系。

五、特征空间在数据科学中的运用

一旦我们将某些现象或过程表示为由许多特征所定义的一组对象,并将此表示形式概念化为多维空间,许多分析操作就可能实现。数据科学的许多基本应用明确或隐含地对应于这种不同的操作。

例如,我们可以使用一组称为探索性数据分析(如下所述)的技术来“查看”空间的结构并将其可视化。为了实现聚类分析,我们将空间划分为多个部分,每个部分包含彼此更相似的点,其他点则在此部分外。在分类中,我们标识属于两个或多个类别的点。(“二进制分类”涉及两个类别;“多类分类”则处理两个以上类别。)如果聚类分析和分类听起来相似,那是因为它们确实如此,但第一个是完全自动化的技术,分类则需要一些已经具有类别信息的数据。在许多搜索算法中,计算机在空间中找到与输入词最相似的点(这些是在特征空间中最接近输入的点——请参阅下面的特征空间中测量距离的部分)。某些推荐算法的工作方式类似——从用户以前喜欢的点开始,它们查找并显示离这些点最近的其他点(当然它们不会直接显示点,而是显示由它们表示的媒体对象,例如电影、歌曲或在社交媒体值得关注的人等)。

这些操作依赖于更基本的操作,例如计算特征空间中点的相似性或差异性。程度或相似性/差异性,可以等同于空间中点之间的简单几何距离。

我想再提几个术语,因为它们在数据科学中非常普遍,以至于你不可避免地会遇到它们:“探索性数据分析”也称为”无监督学习”;相反,“有监督学习”需要部分已标记为属于此类别或其他类别的数据。然后,算法使用标记过的数据及其特征来“学习”如何对新数据进行分类。无监督学习的实际应用是“预测分析”领域的一部分。

在数据科学的当代应用中,最常见的可能是自动分类。然而,在我看来,这是人文学科最不感兴趣的。我们为什么要用计算机将文物、现象或活动分为少数几个类别?为什么不用计算方法来质疑审视我们已经拥有的类别、生成新的类别,或者以原始的方式关联文物来创建新的文化地图?这便是本文没有详细介绍标准数据科学教科书和课程中广泛使用的数据科学方法,即分类方法的原因。但是,虽然这些教科书通常只用于探索性数据勘探,我认为,对于人文学科,我们需要扭转这一比例。

因此,在本文的剩下部分,我将讨论数据勘探技术。

六、特征空间中距离的差异

我们了解到,我们可以在多维空间中将具有许多特征的一组对象概念化为点。对人文学科而言,这样的体现方式有什么好处?

迄今为止,最基本的人文科学方法与日常的人类感知和认知方法相同之处是比较(这与自然科学和社会科学不同,这些学科一直使用数学、统计、数据可视化、计算和模拟来研究其现象和对象)。在 20 世纪的艺术史课程中,双幻灯片投影仪设置允许同时查看和比较两件文物。今天在一个艺术博物馆里,一件文物旁边贴着一个标签,指出这个文物和同一展览中其他几个文物(或艺术家)之间的相似性。

人工比较不能很好地测量大数据。例如,我们实验室的项目“On Broadway”利用许多数据源来可视化纽约的一条街道,我们在 2014 年持续五个月收集了整个纽约市区域所有公开可见的Instagram图像。结果得到1050 万张图像。假设我们想要了解这个当代的地方性摄影的精美样本中的一些模式——这些图像的主题是什么,什么是常见和不常见的构图,纽约市的各个部分之间可能有何不同,使用的人有多少图像专业商业摄影技术等。简单地一起看所有这些图像,将不能让我们的问题得到解答。事实上,没有流行的商业或免费图像管理、共享软件或Web服务甚至也可以将许多图像显示在单个屏幕上。

但是,数据科学技术可以让我们回答诸如我上面为非常大的数据集提出的问题。通过将每个图像表示为许多特征空间中的点,我们现在可以定量地比较它们。在这种表示中,图像之间的视觉差异等同于要素空间中的距离。这使我们能够使用计算机计算尽可能多的图像(或其他类型的文化对象)之间的差异。然后,这种计算成为执行其他更“高级”操作的基础:查找类似图像的群集;确定最受欢迎和最不寻常的图像类型;分离使用专业摄影语言的照片等等[10]。

[10] 对于现在的第一批出版物之一,大型照片数据集的计算分析领域很大,请参阅瑞特德拉·达塔等人的会议论文(Ritendra Datta, et al., “Studying aesthetics in photographic images using a computational approach,” ECCV’06 Proceedings of the 9th European conference on Computer Vision, Volume Part III, 2006, pp. 288-301)。

仅使用两个特征对提高在多维要素空间中测量距离的直觉很有用。考虑图 3 中的可视化效果,显示使用平均亮度(X 轴)和颜色饱和度(Y 轴)的梵高绘画图像。任意两个图像之间的几何距离对应于它们在亮度和饱和度上的差异。请注意,当然,此示例忽略所有其他类型的差异:主题、构图、调色板、画笔等。然而,这不仅是一个限制,而且是一个优势——通过让我们隔离特定特征,我们只能在我们想要的维度上比较文化产品。

我们还可以计算和添加所需的尽可能多的特征。尽管我们可能无法直接可视化和直接查看有50或500个特征的空间,但我们仍然可以计算此空间中点之间的距离。如果两点之间的距离较小,则表示相应的对象彼此相似。如果两个点之间的距离很大,则表示相应的对象彼此不同。

定义和计算距离的方法有很多,数据科学便使用其中的许多种。最容易理解的一种流行方法是使用欧几里得几何(另一种流行的方法是“余弦相似性”,定义为特征空间中两个向量夹角的余弦)。请注意,在这些计算中,我们不需要对所有特征给予同等权重;如果我们认为其中一些更重要,我们也可以在计算中给它们赋予更高权重。

几何特征空间的概念使我们能够采用最基本的人文方法——比较,并将其扩展到文化大数据。同时,它允许我们(如果你愿意的话,也可以表达为“迫使”我们)去量化差异的具体概念和程度。我们现在可以用数字表达这些关系,而不是简单地说工件“A”类似于工件“B”,“A”和“B”与“C”不同。虽然如果我们只考虑少量的文化产品,这种量化可能看起来是不必要的,但一旦我们开始处理数千件、数万计、数百万件甚至更多,它成为一个非常有用的比较方式。

七、探索特征空间

假设我们要了解特定时期的一些文化领域——明代中国画、19世纪末欧洲现实主义艺术、20世纪90年代的平面设计、2010年代初的社交媒体摄影等。存在哪些主题(如果字段有主题)、样式和技术?它们如何随着时间的推移而发展?其中哪一个更受欢迎,哪些更不受欢迎?迄今为止,艺术史学家依靠人脑的进化能力来观察模式,并了解一组文物之间的相似性和差异。他们似乎即便没有使用数学、图形方法、统计、计算或当代数据科学,也做得很好。但是,这种“成功”的代价是最极端的排斥——只考虑每个时期或领域“重要”或“最佳”作品的微小样本。用数字人文学科的先驱弗兰科·莫里蒂(Franko Moretti)的话说:

“研究世界文学是什么意思?我们如何做到这一点?我研究1790年至1930年间的西欧叙述文学,就已经感觉自己像英国或法国以外的骗子……‘我研究西欧叙事等……’不完全是,我工作在它的规范部分,这甚至占不到出版文学的1%。再次,有些人读了更多,但问题是,19世纪有三万部英国小说,还是四万、五万、六万——没有人真正知道,没有人读过那些书,将来也没有人会。此外还有法国小说、中国小说、阿根廷小说、美国小说……” [11]

[11] Franko Moretti, “Conjectures on World Literature,” New Left Review, Vol. 1, January-February, 2000, p. 55, http://newleftreview.org/II/1/franco-moretticonjectures-on-world-literature (accessed April 24, 2015).

莫尔蒂的观点显然也适用于所有其他人文领域;甚至在当代文化的分析中显得尤为契合。谁能看到Instagram每小时分享的哪怕是一小部分照片,或者例如有数千万张带有“#时尚”(#fashion)标签的Instagram照片?谁能在一个月内访问全球数百个城市,去了解所有这些城市在街头时尚方面的差异?谁可以浏览数十亿个网页来了解当前网页设计的景观?

让我们将我们学到的概念——对象、特征、特征空间、特征空间中的距离以及适合的各种操作(探索、聚类等)应用于此问题。首要的,我们需要创建一个适当的数据集。正如我们已经知道的,这意味着将某些文化领域表示为具有各种特征的大型特征集,每个特征捕获对象的某些特性。这些功能可以使用现有的元数据(如日期或名称),由计算机自动提取,或手动添加(在社会科学中,此过程称为“编码”,在人文学科中,我们称之为“注释”或“标记”)。

这些物品可以是照片、歌曲、小说、绘画、网站、用户等在社交网络上生成的内容,或者使用某些标准选择的任何大量的其他工艺品。如果我们想要了解单个创作者的作品是如何相互关联的,它们都可以是他/她的所有作品。除工艺品外,我们所代表的对象也可以是个体文化消费者,其特征可以代表其文化活动的某些特征:例如,一个人访问的网站、一个沉思的轨迹以及查看特定艺术品的时间,或者自拍照片中人脸的位置(请参阅我们的项目网站http://www.selfiecity.net来分析此类数据)。

一旦我们将某些文化或文化活动字段表示为数据(对象及其特征),我们可以将每个对象概念化为多维特征空间中的点。这使我们能够使用数据科学的“探索性数据分析”技术以及数据可视化领域的技术来调查此特征空间的“形状”。

空间可能具有不同的结构:所有点可以聚集在一起,或形成几个聚类,或彼此大致相等的距离等等。任何这些模式都将有适当的文化解释。如果大多数点形成单个群集,这意味着在特定文化领域中,大多数作品/活动具有相似特征,只有少量显著不同。或者,我们可以找到几个彼此相距较远的大型聚类(这可以通过测量集群中心之间的距离来量化)。如果我们发现没有集群,这意味着给定的文化空间具有很高的差异性,而且每一项作品都明显不同于其他作品[12]。

[12] See Lev Manovich, “Mondrian vs Rothko: footprints and evolution in style space,” 2011, http://lab.softwarestudies.com/2011/06/mondrianvs-rothko-footprints-and.html (accessed April 24, 2015).

请注意,正如梵高的示例一样,即使我们使用许多不同的特征,我们也不能确定我们捕获了用以量化差异的正确信息。但是,生成单个“正确”地图不应成为我们的主要目标。算法的每个特征和参数选择都将创建我们感兴趣的不同文物地图。每张地图都能向我们展示一些新的东西。

使用现代数据分析和可视化软件,我们可以快速生成相同数据的多个视图并进行比较。这有助于我们扩大对文化现象的理解,并注意到我们以前没有注意到的关系和模式。换句话说,数据科学不仅允许我们看到对于辅助感知和认知过大的数据;它还允许我们以不同的方式查看任何大小的数据(包括非常熟悉的规范文化数据集)。

八、降维

我们想要探索特征空间的结构:聚类的存在、位置和形状、它们之间的距离以及各个点之间的平均距离。如何做到这一点?如果我们能想象这个空间,那将会很棒。如果我们只有两个特征,我们可以直接将它们分别映射到一个维度并创建传统的二维散点图。如果我们有许多特征,则多维空间可以表示为一系列单独的散点图,每个图显示一对特征。这种可视化技术称为散点图矩阵。

如果我们有很多维度,散点图矩阵就变得不那么有用了。每个绘图仅显示空间在两个维度上的特定投影,即单个平面。如果点聚形的形状是真正多维的,则研究大量单独的二维图可能无助于我们查看这些形状。

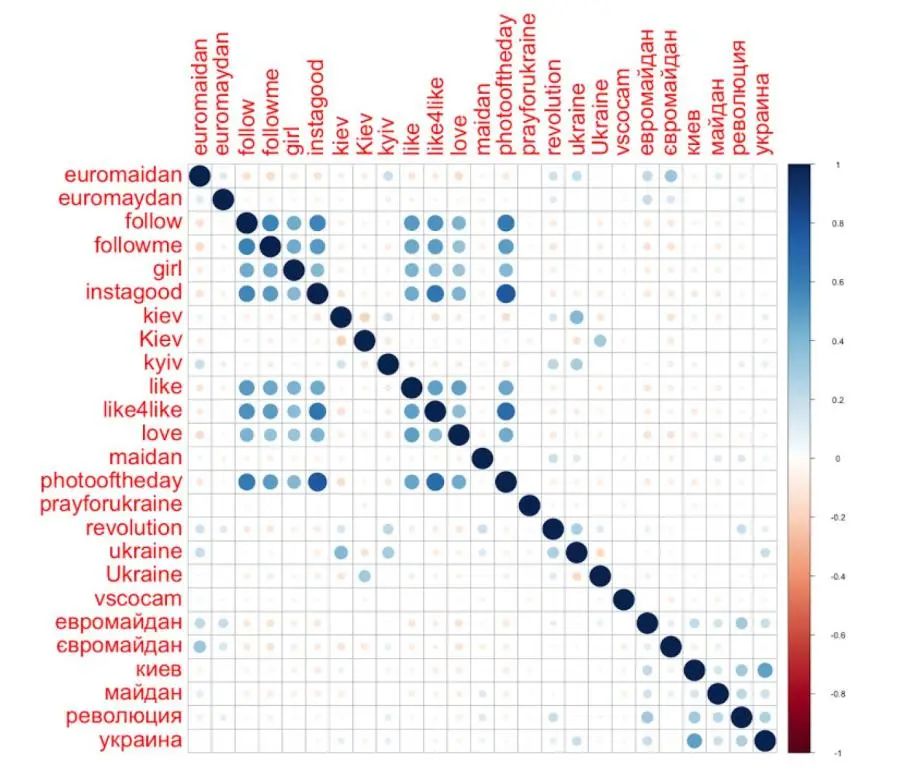

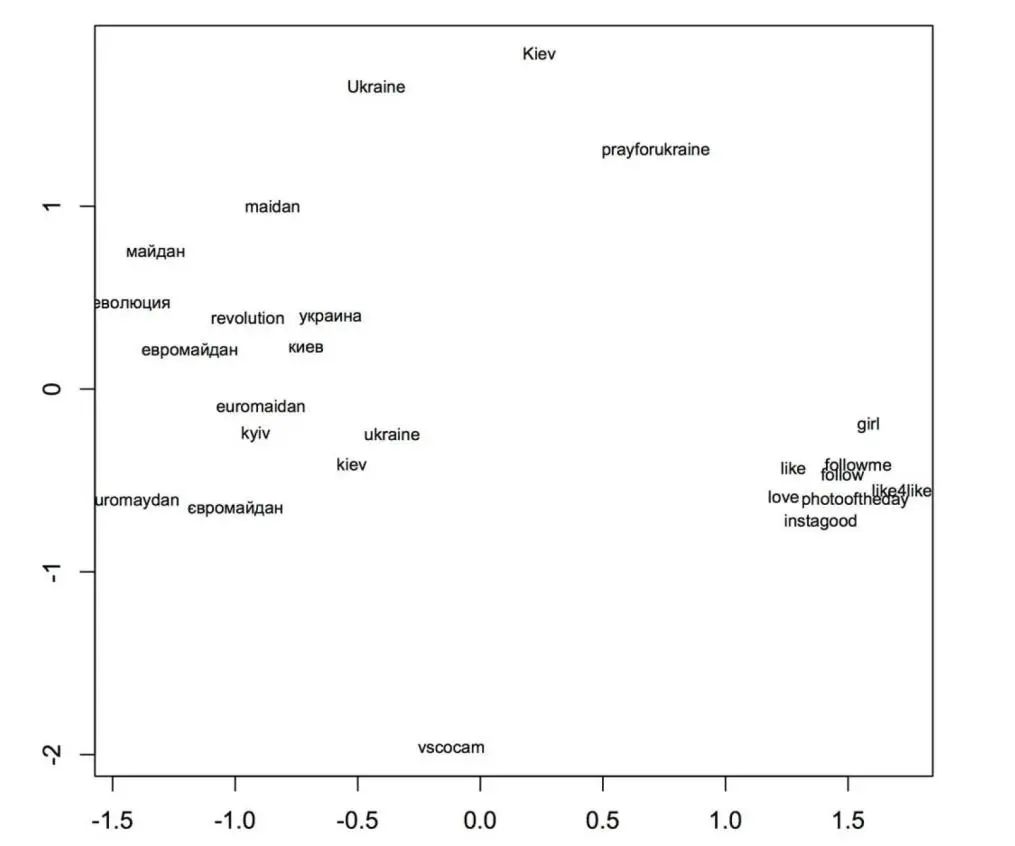

图4 2014年2月乌克兰迈丹(Maidan/独立广场革命)革命期间,Instagram用户在基辅市中心所共享图像的热门标签的热图可视化。使用 Instagram API,我们收集了2月17-22日的图像。在此期间,6165名Instagram用户共享了13208张图像,这些图像共标记了21465个标签(5845个唯一标签)。可视化显示25个最常用的标记。颜色/大小的强度指示两个标记一起使用的频率(列夫·马诺维奇的可视化作品/软件研究计划)。

在具有许多维度(即许多特征)的空间中可视化点的另一种方法是使用距离矩阵。距离矩阵直接从数据表中计算。在距离矩阵中,每个单元格表示原始表的两个对象之间的数值距离。通过将单元格的值转换为灰色色调、颜色或形状,我们可以将距离矩阵转换为可视化效果。这种可视化称为热图。与散点图矩阵一样,热图在添加特征时也会迅速变得非常密集,并且它们也有相同的限制,使难以看到多维聚类的形状。图 4 是热图可视化的示例,用于探索 Instagram 用户分配给他们共享的图像的标记。

数据科学开发了另一种查看和解释多维空间结构的方法。它称为降维。除了对象、特征、要素空间和距离外,降维也是数据科学对人文学科具有重要意义的另一个基本概念。

降维是当今用于探索具有任意更多特征的数据的最广泛使用的方法。它是指创建多维空间的低维表示形式的各种算法。如果此新表示形式仅具有两个或三个维度,则可以使用一个或两个标准二维散点图来可视化它。

请注意,此类散点图中的每个轴通常不再对应于单个特征。相反,它表示各种特征的组合。这是降维算法的严峻挑战——虽然它们允许我们使用散点图来表示数据,以便我们很容易地看到空间的结构,但解释每个维度的含义可能相当困难。但是,即使我们不能确切说出每个轴代表什么,我们仍然可以研究空间的形状、聚类的存在或不存在,以及点之间的相对距离。

降维是将多维空间投影到较少的维度中,就像人的影子是将身体从三维投影成两维一样。根据太阳的位置,一些阴影会比其他阴影信息量更大。(例如,如果太阳就在我头顶上,我的影子就会变得很短,我的身体形状以非常扭曲的方式表示。但是,如果太阳在30度或45度角的位置,我的影子将包含更多信息。同样,维度还原的概念是尽可能保留原始信息。但必须记住,降维过程中某些信息总是会丢失。

不同的降维技术对应保留何种信息以及如何实现这些信息使用不同的标准。以下是三种常见的使用了降维的数据探索方法:

多维缩放 (MDS):我们希望在将多维空间投影到较低维空间的同时,保留多维空间中点之间的相对距离。

主成分分析(PCA):我们希望在从多维转到低维时保留大多数可变性(数据分布)。

因子分析:与多维缩放和主成分分析类似,但其原始动机不同。因子分析的想法是提取“因子”——用少数的“隐藏”变量来负责较大的观测(记录、测量)变量集[13]。

[13] 关于心理学因素分析的原创公式之一,见路易·莱昂·瑟斯顿的论文:Louis Leon Thurstone,“Vectors of Mind,” Psychological Review, Vol. 41, 1934, pp.1-32, http://psychclassics.yorku.ca/Thurstone (accessed April 24, 2015)。

图5是多维缩放可视化的示例。我们探索了2014 年 2 月乌克兰迈丹革命期间基辅排名前25的Instagram 标签的13208 幅图像,并发现了不同的语义簇。

图5 使用多维缩放 (MDS) 可视化图 4 中的数据。通常一起使用的标记在绘图中彼此接近。在右侧,我们看到表示“通用”Instagram 语言的标记的紧密群集:#like、#follow、#instagood 等。(这些相同的标签在世界各地很流行)。在左边,我们看到另一组与迈丹革命相关的标记。可视化显示表明,这两种类型的标记之间几乎没有交互:一组 Instagram 用户使用通用标记,而另一组主要标记本地和特定事件。

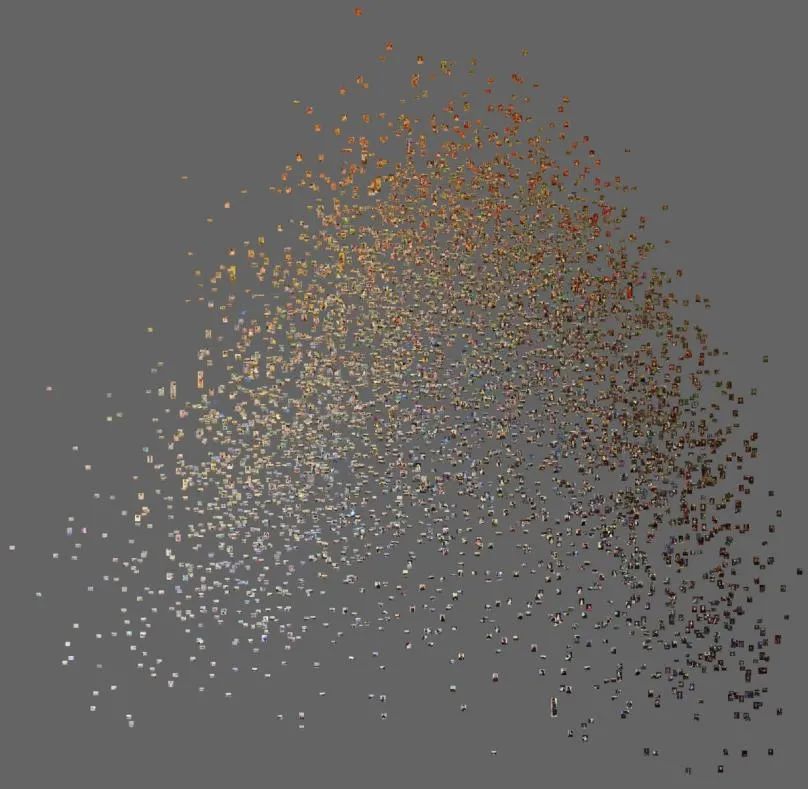

图6显示了使用主成分分析的大约 6000 幅法国印象派绘画的可视化示例。在这种可视化中,与特定视觉特征方面相似的图像将组合在一起。这种可视化功能使我们能够将许多图像相互比较,并了解大型可视化数据集中的相似性和差异模式。

图6 使用主成分分析的图像集合可视化示例。数据集是法国印象派约6000幅画作的数字图像。我们从每个图像中提取了200个单独的特征,描述了其颜色特征、对比度、形状、纹理和合成的某些方面。然后,我们使用主成分分析将有200个特征的空间缩小到较低的维度,并将前两个维度可视化。在可视化效果中,从我们所提取的特征方面相似的图像被聚集在一起。一个有趣的发现是,与印象主义(左下角)相关的图像类型只占这些艺术家创作的更大作品集的一小部分。至少有一半的图像是比较传统和更典型的古典19世纪绘画(较暗的色调和温暖的颜色)。注:我们的数据集仅包含1874-1886年印象派展览参与者创作的所有油画和蜡笔画的大约二分之一(列夫·马诺维奇的可视化作品/软件研究计划)。

结语

探索就是比较。想要比较,我们首先需要理解,要理解文化大数据,我们需要转向数据科学。

直到21世纪,我们通常比较少量的人工制品的情况下,没有机器的帮助,人类的认知能力也被认为是足够的。但是今天,如果我们想要比较数以万计或数百万件文化产品(数字用户生成的内容是此类比例的一个最佳示例,但一些数字化的历史文物收藏也可以相当大),我们别无选择,只能使用计算方法。换句话说:要“看到”当代文化,需要使用计算机和数据科学。

这种计算机“视觉”可以作为人文学科最基本的行为(或方法)的延伸——比较文物(或时期、作者、流派、运动、主题、技术、主题等)。因此,尽管数据科学启用的计算机观察在规模上可能是激进的——可以说,你一次“浏览”能看到的内容——但它延续了人文学科的传统方法论。

在本文中,我介绍了数据科学的若干核心概念:对象、特征、特征空间、测量特征空间中的距离、降维。我认为,它们是数据科学领域与人文学科相关的最基础和最根本的概念。它们支持对大数据的探索,但它们也落后于数据科学及其行业应用的其他领域。事实上,它们对于我们的“大数据社会”至关重要,正如我们用来代表和推理世界和彼此的其他主要文化技术一样 ——自然语言、基于镜头的照片和视频成像、用于保存和访问的材料技术信息(纸张、印刷、数字媒体等)、计数或微积分。它们构成了数据社会的“头脑”——接触、理解和作用于我们时代所特有的世界和人类的特殊方式。

END

主编 / 陈静 付梅溪

责编 / 任苗青

美编 / 任苗青

原文始发于微信公众号(零壹Lab):对撞机|数据科学和数字艺术史